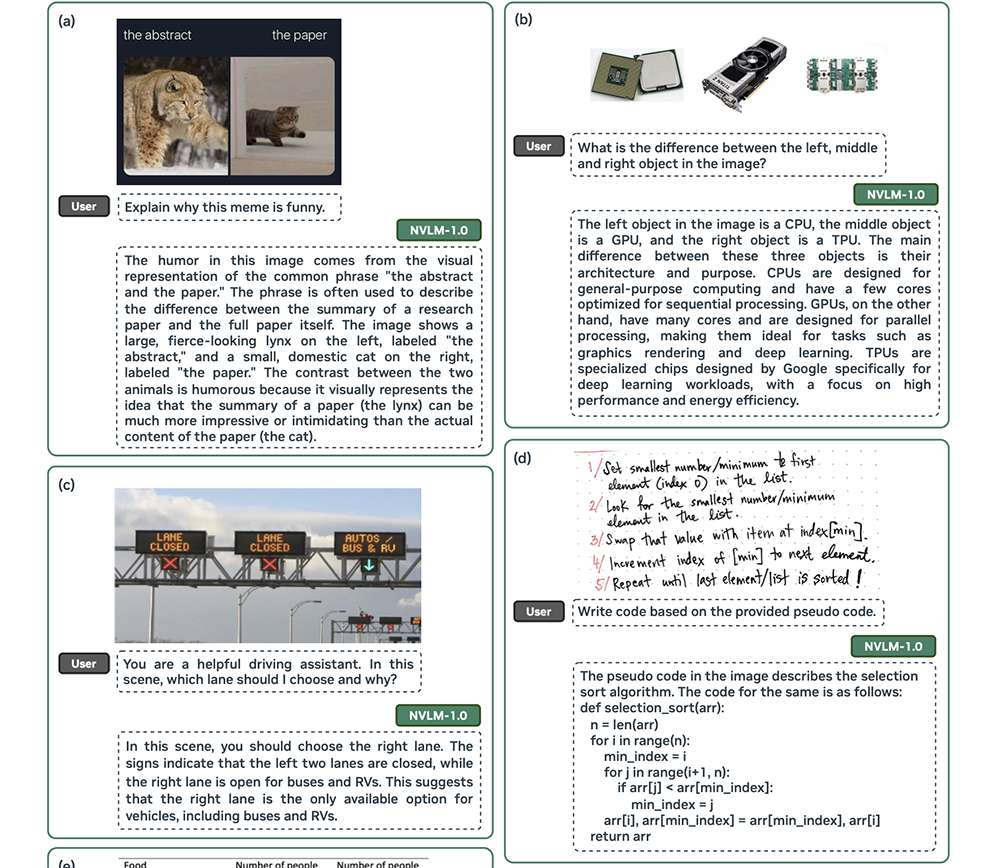

Компания Nvidia представила мультимодальную большую языковую модель под названием NVLM 1.0 (Nvidia Vision Language Model), которая не только отлично справляется с визуальными задачами, но и может интерпретировать картинки, рукописный текст и понимает смысл мемов. Новая нейросеть содержит в себе до 72 млрд. параметров.

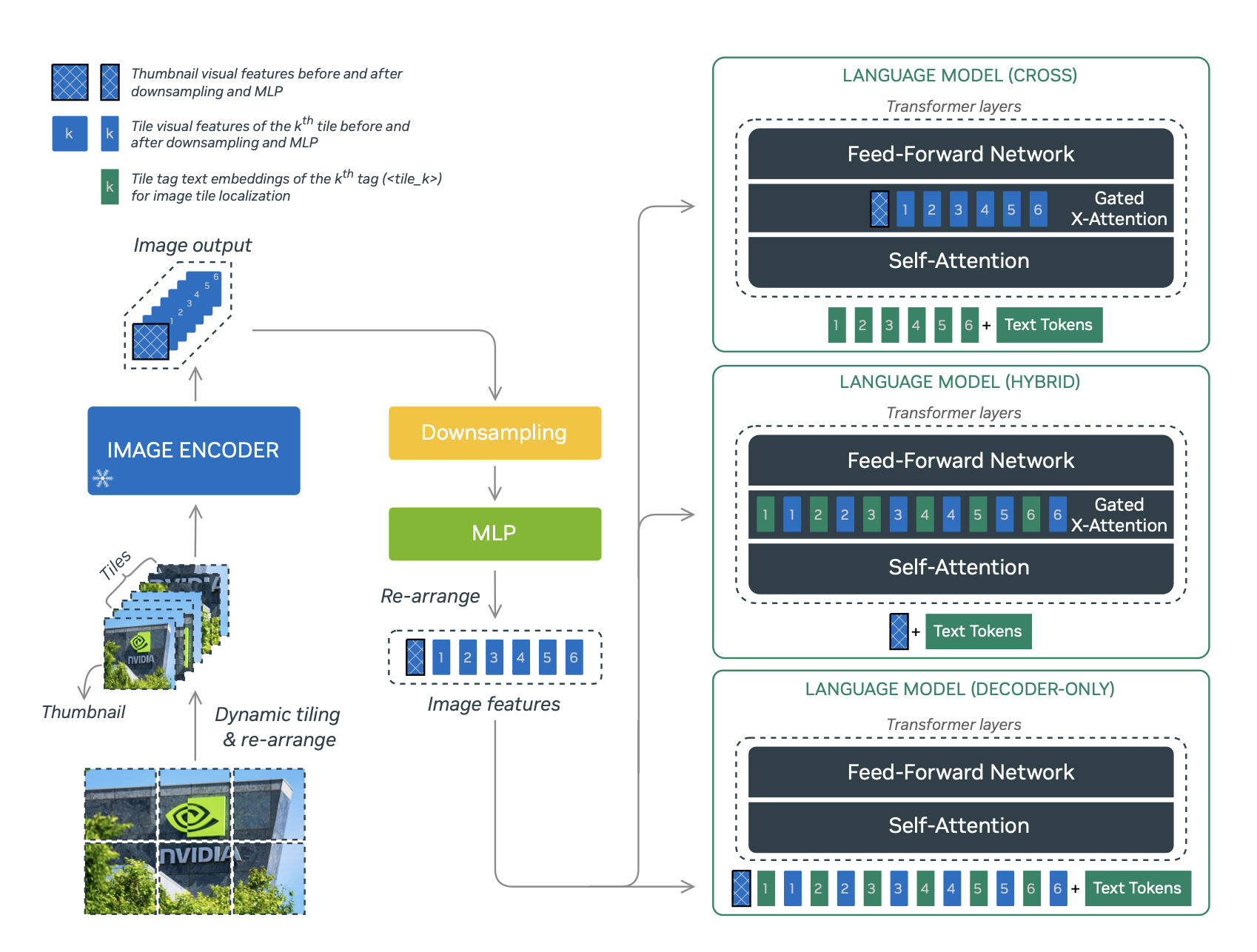

Nvidia выпустила три версии модели: NVLM-D, NVLM-X и NVLM-H. Они имеют схожую архитектуру, но обладают разными особенностями.

- NVLM-D (Decoder-Only Model) — использует предобученный энкодер для генерации картинок и более экономна относительно количества параметров, но потребляет больше ресурсов графического процессора;

- NVLM-X (X-attention Model) — оптимизирована для работы с изображениями в высоком разрешении;

- NVLM-H (Hybrid Model) — гибридная модель, которая сочетает в себе черты двух предыдущих моделей.

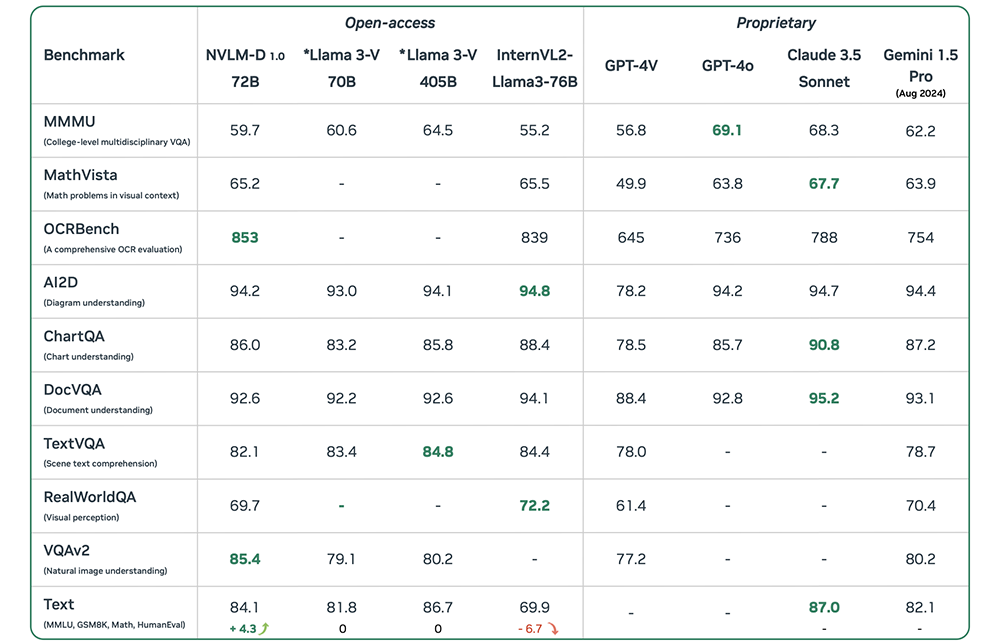

Испытания в бенчмарке OCRBench подтвердили продвинутые возможности NVLM 1.0 по считыванию текста с картинки — нейросеть Nvidia обошла GPT-4o. Кроме того, она хорошо показала себя в математических задачах, опередив Google Gemini 1.5 Pro и уступив всего 3 пункта Claude 3.5 от стартапа Anthropic.

Больше технических деталей можно найти по этой ссылке. Веса всех версий моделей скоро можно будет найти на Hugging Face, доступ к коду — на Github.