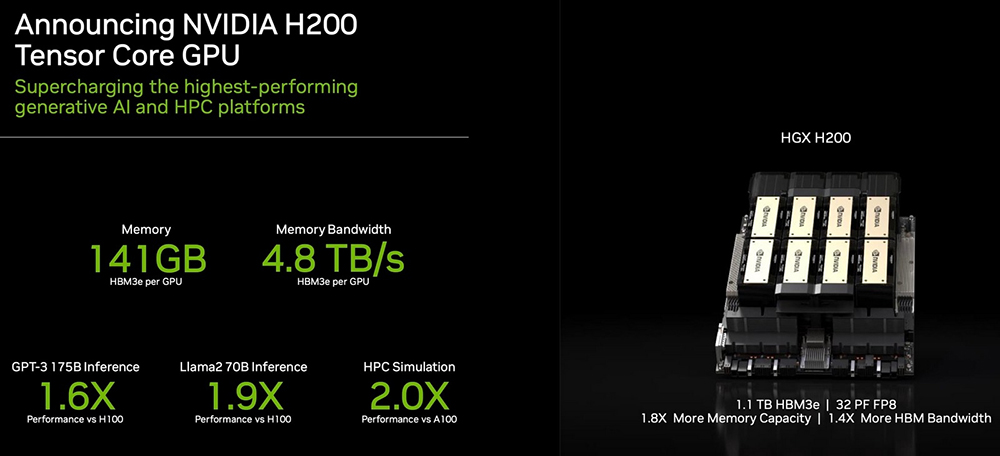

Компания NVIDIA на конференции SC23 представила графический процессор H200, ориентированный на следующее поколение суперкомпьютеров для искусственного интеллекта. Чип построен на архитектуре NVIDIA Hopper и фактически представляет собой обновленную с помощью более скоростной памяти HBM3e версию флагманского H100.

H200 оснащен 141 Gb памяти HBM3e с пропускной способностью 4,8 ТБ/с, что почти вдвое больше по объему и в 2,4 раза больше по пропускной способности по сравнению с памятью ускорителя прошлого поколения A100. За счет более скоростной памяти HBM3e, H200 обеспечит значительный рост производительности в работе уже обученных систем искусственного интеллекта. Например, NVIDIA обещает увеличение скорости работы большой языковой модели Llama 2 с 70 млрд. параметров в 1,9 раза, по сравнению с H100. А работу обученной модели GPT-3 с 175 млрд. параметров новинка ускорит в 1,6 раза.

NVIDIA H200 будет доступен в серверных платах NVIDIA HGX H200 в конфигурациях с четырьмя и восемью ускорителями. Новинки совместимы как с аппаратным, так и с программным обеспечением систем HGX H100. Сообщается, что производители серверов, включая ASRock Rack, ASUS, Dell Technologies, Eviden, GIGABYTE, Hewlett Packard Enterprise, Ingrasys, Lenovo, QCT, Supermicro, Wistron и Wiwynn выпустят свои системы с ускорителями H200. Amazon Web Services, Google Cloud, Microsoft Azure и Oracle Cloud Infrastructure станут одними из первых поставщиков облачных услуг, которые со следующего года начнут предлагать инстансы на базе H200.

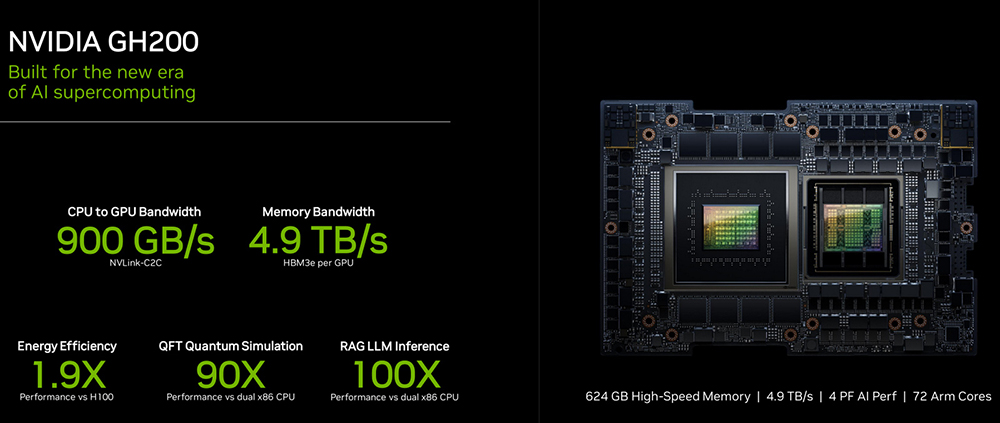

Кроме того, компания анонсировала выход GH200, который сочетает в себе GPU H200 и CPU Grace. Каждый чип GH200 будет содержать объединенную память объемом 624 Gb, что значительно больше, чем у предыдущей версии GH100. Такие интегрированные модули NVIDIA позиционирует в качестве высокопроизводительных решений для работы с приложениями HPC и ИИ огромного масштаба.