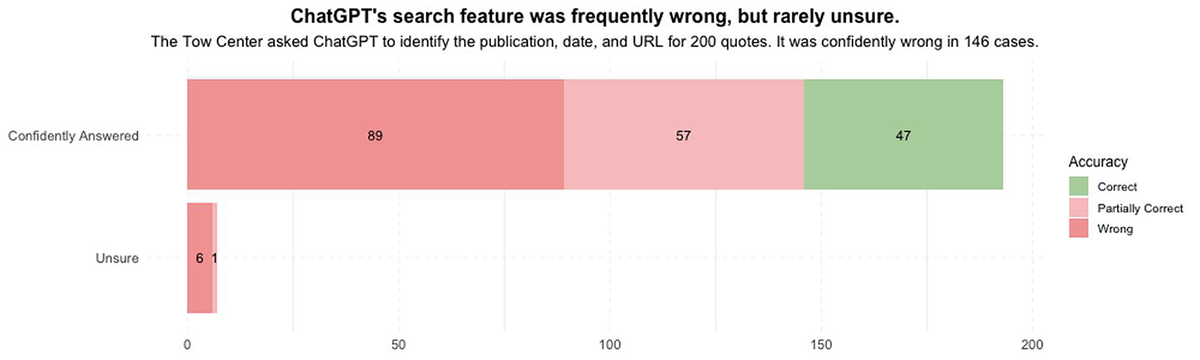

Специалисты Центра цифровой журналистики при Колумбийском университете протестировали поисковую функцию чат-бота ChatGPT от компании OpenAI. Результаты исследования показали, что алгоритм часто предоставляет неточные ответы и затрудняется в поиске достоверных источников новостей.

Запущенный недавно ИИ-поисковик от OpenAI способен давать быстрые ответы со ссылками на соответствующие веб-источники. Но тестирование показало, что сервис испытывает трудности с правильным определением цитат из статей. В частности, исследователи попросили ChatGPT определить источники для 200 цитат из 20 различных публикаций, при этом 40 из них были взяты с сайтов, которые запретили OpenAI доступ к своим материалам.

«В общей сложности ChatGPT выдал частично или полностью неверные ответы в 153 случаях. В только 7 случаях бот признался в невозможности предоставить точный ответ, используя такие выражения как «кажется», «возможно» или «может быть», а также утверждения вроде «я не смог найти точную статью»», — пишут исследователи.

Во время тестов также выявились случаи, когда поисковый инструмент ChatGPT ошибочно связывал цитаты из письма в редакцию Orlando Sentinel с материалами журнала Time. В другом примере его попросили найти источник цитаты из статьи The New York Times о находящихся под угрозой исчезновения китах, а ChatGPT выдал ссылку на сайт, который просто скопировал и опубликовал оригинальную статью без изменений.