Что могут нейронные сети

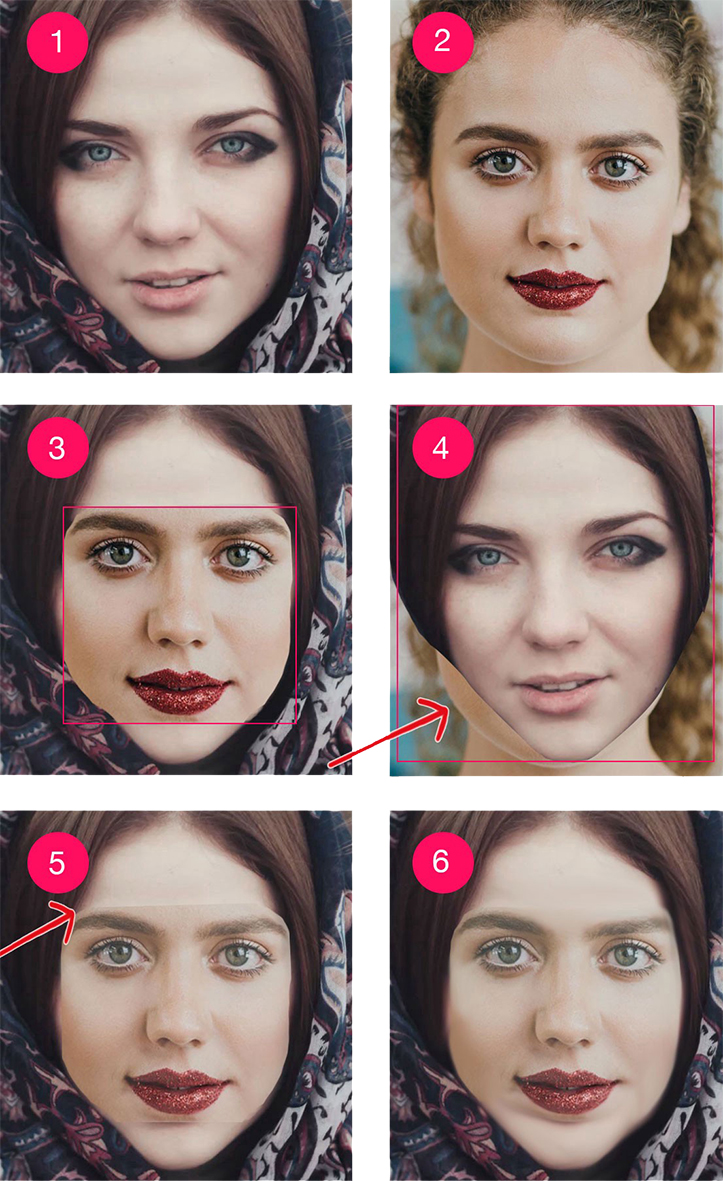

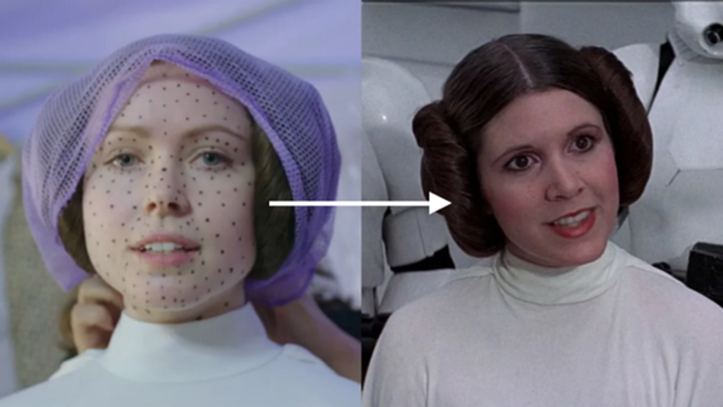

Технология DeepFake становится предметом пристального внимания не только журналистов, но и IТ-аналитиков, которые называют эту технологию одним из наиболее опасных изобретений последних лет. Опасность этой технологии признают даже ведущие политики разных стран. Своим появлением DeepFake обязана генеративно-состязательным нейросетям (Generative Adversarial Network — GAN). Механизм их работы заложен в двух противоборствующих алгоритмах. Первый обучается на предоставленных ему фотографиях, чтобы сформировать реалистичную подмену лица, а второй отсекает неудачные варианты до тех пор, пока сам не начнет путать копию и оригинал. Для создания подделки и первой, и второй нейросети нужно множество примеров фотографий человека в разных ракурсах, позах и с разной мимикой. После анализа таких изображений алгоритм GAN начинает генерировать поддельные фотографии, а позже DeepFake-инструменты помогут добавить такие фотографии в видеоролик. Алгоритмы GAN используются многими компаниями и научными учреждениями, например, физики-ядерщики применяют их для прогнозирования поведения частиц, а врачи для улучшения качества изображений. А компания Google еще 5 лет назад представила общедоступный набор программных инструментов под названием TensorFlow, который помогает в обучении генеративно-состязательных нейросетей. Кроме визуального синтезирования, генеративно-состязательные нейросети уже умеют работать и с голосом. Например, такие стартапы как Lyrebird и iSpeech умеют создавать звуковые примеры на основе голосов людей. Иными словами, такие стартапы могут получить запись голоса, проанализировать ее и создать максимально-реальную его копию, но уже для озвучивания других фраз.

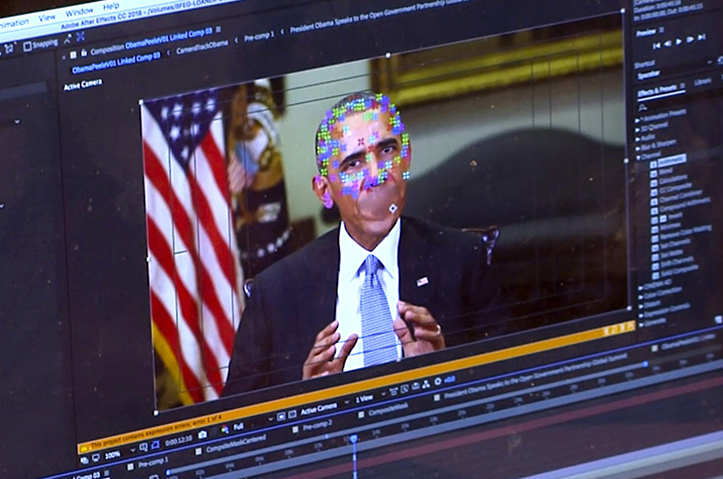

Название DeepFake представляет собой комбинацию двух терминов: «Deep» («глубокий») и «Fake» («подделка»). В этом названии первая часть — это сокращение термина «Deep Learning». Первое публичное появление технологии произошло на Reddit, где лица таких звезд, как Галь Гадот, Скарлетт Йоханссон, Тейлор Свифт, Эмма Уотсон и Кэти Перри, были использованы в роликах эротической направленности. Позднее эти видео появились в Facebook и других социальных сетях. Скандал был настолько громким, что о борьбе с DeepFake заговорил лично глава Facebook Марк Цукерберг, пообещав откорректировать правила публикации. Позднее он и сам стал жертвой технологии. В довольно качественно сделанном ролике его представили говорящим о том, что он контролирует мир с помощью информации. Второй «всплеск популярности» DeepFake пережила, когда появилось видео с президентом США Бараком Обамой. Еще одним примером реализации технологии DeepFake стало интервью Дональда Трампа самому себе.

Но не все работы наносили вред репутации известных людей. Были и довольно безобидные развлечения. Например, одна группа энтузиастов начала заменять лица знаменитых людей в кино и сериалах Николасом Кейджем. В 2018 году была представлена первая публичная программа для подмены лиц под названием FakeApp, которая открыла доступ к инструментам DeepFake простым пользователям. Как оказалось, это был тот самый алгоритм, которым пользовался создатель эротических роликов.

Кроме того, инженеры из Университетов Стэнфорда, Макса Планка и Принстона создали на основе алгоритма DeepFake нейросеть, которая позволяет редактировать речь говорящего на видео так же просто, как текст в текстовом редакторе. Алгоритм получил название Neural Rendering. Ему требуется около 40 минут, чтобы изучить мимику говорящего на видео и сопоставить форму его лица с каждым фонетическим слогом. После этого нейросеть составляет 3D-модель лица говорящего и позволяет редактировать то, что он говорит, изменяя при этом мимику спикера. Исследователи отмечают, что в идеальном мире разработка позволит сократить затраты на пересъемку неудачных дублей. Однако от идеи опубликовать код нейросети ученые отказались, так как предполагают, что она может использоваться для подстановки в ролики слов и выражений, которых спикер на самом деле не произносил.

DeepFake для широких масс

Главная опасность технологии DeepFake состоит в том, что инструменты, которые позволяют сделать все вышеописанное, стали доступны обычным людям. Для работы таких приложений нужны мощные компьютеры, но и это сегодня не является особой проблемой. Как мы уже отметили выше, главным инструментом для создания DeepFake является приложение FakeApp. Несмотря на блокировку оригинального сайта приложения www.fakeapp.org и различных упоминаний и обсуждений его использования, в Сети еще сохранились сайты-зеркала, а на Reddit есть раздел со ссылками на скачивание FakeApp со страниц файловых хостингов Google Drive и анонимного Mega, а также с инструкциями по его применению. Журналист The New York Times Кевин Роуз (Kevin Roose) протестировал работу FakeApp и описал свой опыт. Для создания видео ему пришлось использовать удаленный сервер, арендованный через Google Cloud Platform, который обеспечил достаточную вычислительную мощность. Но даже и в этом случае удаленный сервер генерировал модели более 8 часов, а аренда сервера обошлась в 85,96 доллара. На обычном ноутбуке для такой задачи могут понадобиться дни или даже недели. В эксперименте для первого DeepFake-ролика использовались более 400 фотографий автора статьи и более тысячи снимков актера Райана Гослинга. Даже при этом видео вышло весьма размытым, поэтому позже журналист использовал намного больше фотографий. Эксперимент был интересен еще и тем, что и его участник, и разработчик FakeApp, прокомментировавшие работу приложения, так и остались анонимными. Они не назвали свои настоящие имена и общались с помощью ников и обезличенных адресов электронной почты.

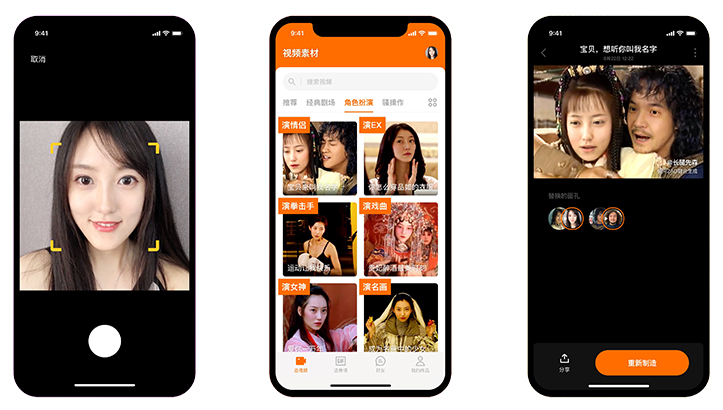

Этим летом в Китае появилось приложение Zao, которое также поддерживает технологию DeepFake. Приложение быстро заняло лидирующие места в китайском App Store, но в то же время стало расти число недовольных Zao. В первую очередь из-за пользовательского соглашения, которое давало разработчикам безграничные и безотзывные права на изображения и видео с лицами пользователей. После скандала соглашение было изменено, а компания заявила, что не будет хранить биометрические данные пользователей. Но ситуация усугубилась тем, что Zao принадлежит сайту знакомств Momo. Общественность напугала возможность того, что их данные могут быть переданы Momo и использованы ею с неопределенными целями. В результате рейтинг Zao моментально упал. В защиту Zao выступил руководитель отдела коммуникаций компании Deeptrace, которая занимается вычислением мошенников и киберпреступников, Генри Эйдер. Он заявил, что приложение не представляет угрозы для общественности, поскольку его функционал ограничен. В нем есть встроенная библиотека видео из различных фильмов и клипов, и поменять лицо можно лишь на предложенных записях. По уверению Эйдера, технология может стать проблемой только в том случае, если у пользователей будет возможность накладывать другие лица на свои собственные видео. Популярная китайская система on-line платежей Alipay заявила, что алгоритмы распознавания лиц гораздо сложнее и точнее, и взломать его при помощи такого приложения невозможно, а китайская платформа для общения WeChat также подтвердила, что Zao не несет угрозы пользователям. Правда, мессенджер ограничил доступ к скандальному приложению, и пользователи Zao не могут отправить друзьям ссылку-приглашение.

Чем опасен Deepfake?

Как считают многие эксперты, развитие технологии DeepFake может оттолкнуть нас на столетия назад, когда видео и фотографии не считались достаточными доказательствами. И действительно, такие технологии совершенствуются с каждым днем, а вот развитие инструментов, способных распознать поддельный контент, пока находится в зачаточном состоянии. Журналистка The Guardian считает, что Deepfake может стать орудием против женщин в интернете, поскольку львиная доля подобного контента приходится на махинации с их лицами для создания продукта эротического содержания. Уже даже появилось такое понятие, как DeepFake-преступность. Широкую огласку получил случай ограбления британской энергетической компании, директору которой позвонил якобы управляющий из Германии. Программа, сымитировав его внешность и акцент, попросила переслать деньги фирме-поставщику из Венгрии. Так компания потеряла 220 тысяч евро.

Опасности, которые несет DeepFake — это не только политическая пропаганда и конкурентная борьба, в которой можно заставить соперника «говорить» откровенную ложь, в которую большинство поверит. DeepFake — это еще и весьма опасный инструмент манипулирования общественным мнением, с помощью которого можно легко посеять панику и страх. Политик, объявляющий о ядерном ударе, или глава полиции, заявляющий о распылении отравляющего газа — все это реалистичные сценарии, которые можно смоделировать с помощью DeepFake. DeepFake в порноиндустрии также может стать обыденным явлением, а скорость распространения таких видеороликов в социальных сетях будет мгновенной. Тем не менее, уже сейчас существуют некоторые методологии, позволяющие определить DeepFake, а в последнее время появились и инструменты для их идентификации.

Стандартные модели обнаружения поддельных видео анализируют видеокадры отдельно и пытаются определить признаки манипуляций. Новая технология требует гораздо меньше вычислительной мощности и времени, так как она «просматривает» видео целиком. После этого она складывает кадры видео друг на друга и ищет возможные несоответствия в том, как перемещается объект съемки. Признаками поддельного видео могут быть движения век человека или странные жесты, которые исследователи называют «мягкими биометрическими подписями». Поскольку большинство поддельных алгоритмов не полностью моделируют движения человека, они и могут выдать поддельные материалы. Так, например, ученые из Института информационных наук США использовали набор данных, состоящий из около 1000 поддельных видео, чтобы обучить новый инструмент. Теперь он может идентифицировать созданные нейросетью видео с точностью до 96%.

Тем не менее, в начале июля 2019 года в Виргинии был принят закон, запрещающий распространение порнографии с подменой лиц. Это первый штат в США, где была запущена подобная инициатива. Начиная с 1 июля 2019 года, любой, кто распространяет или продает фальшивые фотографии и видеоролики сексуального характера с целью шантажа, домогательства или запугивания в этом штате может быть оштрафован на сумму до 2500 долларов. Также предусмотрен тюремный срок до 12 месяцев. Такой же закон вступил в действие с 1 сентября текущего года в Техасе, а в Нью-Йорке рассматривается законопроект, запрещающий создание «цифровых копий» людей без их согласия.

По словам экспертов, выявить подделки становится все сложнее. Компания McAfee, занимающаяся проблемами кибербезопасности, сообщила, что подмену лиц в видео уже нельзя определить невооруженным глазом. В программной речи на конференции по кибербезопасности RSA в Сан-Франциско директор по технологиям McAfee Стив Гробман (Steve Grobman) и главный специалист компании по данным Селеста Фралик (Celeste Fralick) предупредили, что использование новой технологии хакерами — лишь вопрос времени. Теперь, когда злоумышленники способны создать индивидуализированный целевой контент, они могут использовать искусственный интеллект в различных целях, например, для взлома учетных записей с помощью методик социальной психологии или фишинг-атак. Персонализированный фишинг, то есть мошенничество, направленное на получение банковских конфиденциальных данных с целью хищения денег, является более успешным, однако новые возможности искусственного интеллекта позволяют проводить его в масштабах автоматизированных атак. Гробман подчеркнул, что сами по себе технологии DeepFake представляют собой орудие, которое можно использовать в самых различных целях. Запретить злоумышленникам использовать новые методики невозможно, но можно своевременно наладить линию защиты, считает он.

Мы вплотную приблизились к миру, в котором фейк и правда становятся практически неотличимы друг от друга. DeepFake делают фейки настолько реалистичными, что наши слух и зрение не будут способны отличить ложь от правды. Развитие технологий — это не только прогресс, но и появление новых мошеннических схем. Чтобы не стать жертвой, нужно следить за появлением технологических новшеств и всегда перепроверять информацию.