Китайская Alibaba Group представила большую языковую модель (LLM) Qwen3-Max-Preview с 1 трлн. параметров. Это самая большая на сегодняшний день LLM модель. Qwen3-Max-Preview, как понятно из названия, пока является предварительной версией модели.

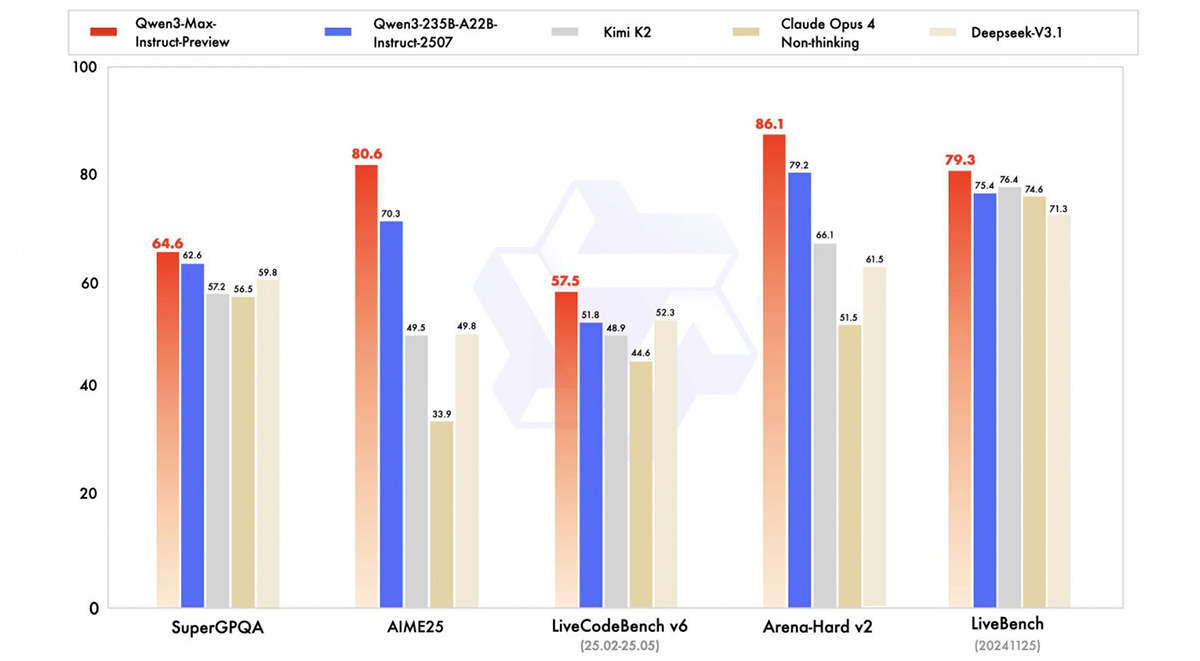

Qwen3-Max предназначается для сложных рассуждений (но режим «Мышление» в Qwen Chat пока недоступен), написания программного кода, обработки структурированных форматов данных, включая JSON, а также для задач творческого характера. По результатам тестов SuperGPQA, AIME25, LiveCodeBench v6, Arena-Hard v2 и LiveBench (20241125), опубликованные китайскими разработчиками, Qwen3-Max-Preview опережает Claude Opus 4, Kimi K2 и DeepSeek-V3.1.

Новая ИИ-модель уже доступна на веб-сайте Qwen Chat, через облачный API Alibaba и OpenRouter, а также в AnyCoder. В отличие от других систем Alibaba, Qwen3-Max-Preview пока не доступна по лицензии с открытым исходным кодом, и для ее подключения разработчикам пока придется довольствоваться платным API самой компании или ее партнеров.

На практике модель реже дает сбои в таких задачах с подвохом как, например, сравнение одинаковых чисел или подсчет количества заданных букв в указанном слове. Не все современные ИИ пока на это способны. На платформе Qwen Chat она также работает быстрее, чем ChatGPT. Qwen3-Max-Preview поддерживает контекстное окно длиной 262 144 токенов, максимальный объем запроса — 258 048 токенов, максимальная длина ответа — 32 768 токенов. Поддерживается кеширование контекста.

Цены:

- 0–32 тыс. токенов — $0,861 за 1 млн. входящих и $3,441 за 1 млн. исходящих токенов;

- 32 тыс.–128 тыс. токенов — $1,434 за 1 млн. входящих и $5,735 за 1 млн. исходящих токенов;

- 128 тыс.–252 тыс. токенов — $2,151 за 1 млн. входящих и $8,602 за 1 млн. исходящих токенов.