Центр обработки данных обычно является масштабным зданием, внутри которого функционируют серверное и сетевое оборудование. Без data-центров сегодня было бы немыслимо существование интернета, ведь именно на серверах хранится то, что определяется словом «контент». Отправка электронной почты, оплата услуг в уличных терминалах или простой звонок по мобильному телефону — все это генерирует внушительные объемы трафика в глобальной сети. Все чаще data-центры сооружаются в необычных местах, с естественными природными и геологическими условиями, позволяющими поднять уровень безопасности, снизить уровень потребления электроэнергии и повысить возможность использования естественной среды для охлаждения. Сегодня мы познакомим вас с самыми яркими идеями в вопросах построения центров обработки данных.

Data-центр Pionen в Швеции

Pionen — один из дата-центров шведского интернет-провайдера Bahnhof, открытый в 2008 году. Еще несколько лет назад здесь располагались серверы WikiLeaks. Data-центр находится на юге Стокгольма в районе Седермальм. Но самое примечательное, что он располагается внутри горы, в которой во время холодной войны было сооружено ядерное бомбоубежище. Бункер, находящийся на глубине 30 м, укреплен кладкой из гранита и оборудован дверью толщиной 40 см и двумя мощными электрогенераторами, которые в случае отключения электроэнергии запускаются автоматически.

Пройти к data-центру можно через единственный тоннель, что делает его почти недоступным для физического захвата или уничтожения серверов. Компании Bahnhof пришлось своими силами пробиваться вглубь горы, чтобы добавить 4000 м3 дополнительного пространства. Изначально полезная площадь бомбоубежища составляла 1110 м2. Специалисты Bahnhof решили сохранить неотделанные каменные стены при создании интерьера data-центра. При этом они добавили растения, чтобы имитировать пребывание на открытом воздухе для повышения комфорта людей, работающих под землей. Конференц-зал, который буквально подвешен над машинными залами с серверным оборудованием клиентов компании, напоминает базу внутри кратера на Луне.

Data-центры CERN

10000 серверов Европейского центра ядерных исследований (CERN) находятся в комнате на нулевом этаже офиса CERN недалеко от Большого адронного коллайдера (БАК). Они работают круглосуточно и без выходных. Еще один data-центр находится в Научно-исследовательском центре им. Вигнера в Венгрии. Data-центры постоянно обмениваются данными между собой через две независимые выделенные цепочки. Следует отметить, что эксперименты с БАК приносят более 30 петабайт информации в год. Они переносятся в центр обработки данных, где выполняется первоначальная реконструкция данных и их архивирование. Еще более 100 петабайт хранится в системах массового хранения.

CERN управляет своими data-центрами, разделяя их на категории согласно механизму классификации Tier, но в данном случае речь идет не об уровнях надежности IT-инфраструктуры, представленных в системе сертификации Uptime Institute. В случае с CERN основной data-центр именуется Tier 0, равно как и ЦОД в исследовательском центре им. Вигнера. Из этих объектов информация передается на объекты 11 других исследовательских организаций (Tier 1), которые представляют собой второй уровень системы обработки информации.

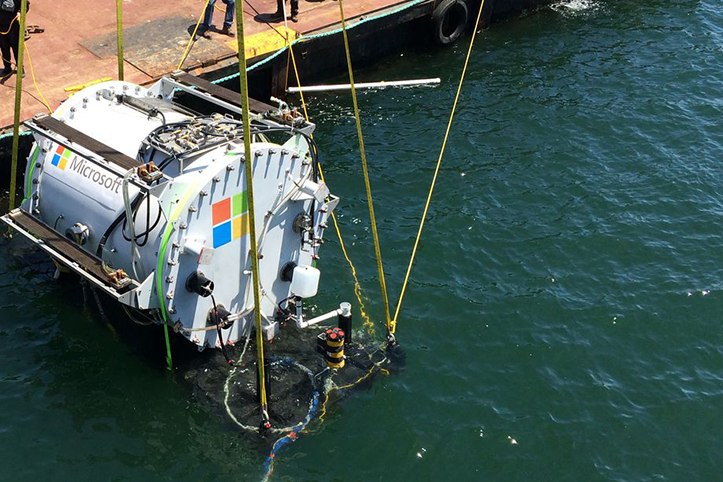

Как Microsoft «топит» data-центры

Первый подводный эксперимент с data-центром компания Microsoft провела еще в 2015 году. Тогда контейнер под названием Leona Philpot затопили на 5 месяцев. Сейчас же Microsoft в рамках проекта Project Natick создала еще один подводный data-центр с 864 серверами и опустила его на глубину 35,7 м около Оркнейских островов в Шотландии. Data-центр подключен к источнику питания и интернету подводным кабелем, который тянется к островам под водой. Планируется, что сервера будут использовать морскую воду для охлаждения, чтобы снизить расходы на их содержание. Экономия произойдет и за счет аренды земли, которая в данном случае просто не нужна. В ближайший год компания будет анализировать состояние data-центра, температуру внутри капсул и герметичность корпуса, после чего примет решение о целесообразности продолжения такого эксперимента. По мнению разработчиков, такой data-центр рассчитан минимум на 5 лет работы без необходимости в обслуживании. Если Project Natick докажет свою успешность, то на следующем этапе Microsoft планирует погружать группы по 5 модулей. Одновременно будет проверена возможность разворачивать в море data-центры в течение 90 суток.

Данный эксперимент проведен в сотрудничестве с несколькими компаниями. Французская Naval Group соорудила и оборудовала герметичные контейнеры. После проверки всех систем data-центр погрузили на грузовик и перевезли из Франции в Шотландию, где его прикрепили к заполненной балластом треугольной базе для развертывания на морском дне. Другой партнер в лице компании European Marine Energy Centre (EMEC), которая специализируется на прокладке подводных кабелей для подключения морских ветряных энергетических установок и других объектов, помог проложить кабели и подключить data-центр к береговым узлам.

В качестве дополнительного преимущества здесь выступает и отсутствие необходимости в человеческом персонале в таких data-центрах. Воздух с водяными парами и вредным кислородом в серверных заменяют осушенным азотом. За счет этого существенно снижается коррозия и износ металлических деталей. Конечно, в таких условиях невозможно заменить вышедшее из строя оборудование, но инициаторы проекта надеются, что сами условия эксплуатации способствуют снижению количества сбоев и отказов оборудования.

The Barcelona Supercomputer Center (BSC) в бывшей церкви Chapel Torre Girona

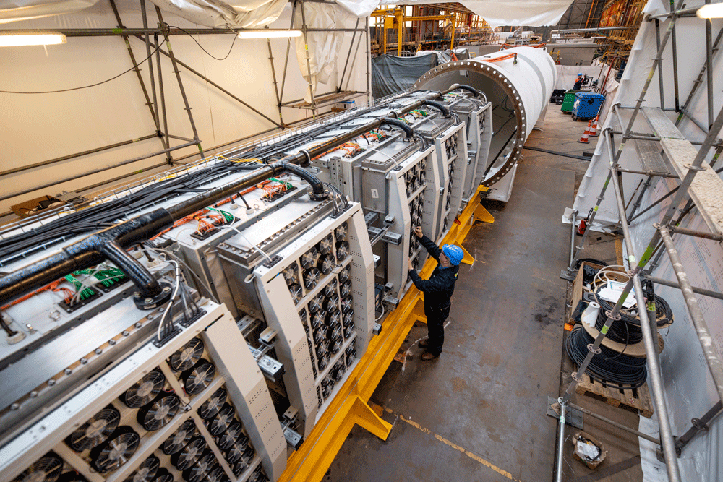

В марте 2004 года правительство Испании и IBM подписали соглашение о строительстве одного из самых мощных суперкомпьютеров в Европе. В 2005 году на базе Каталонского Политехнического Университета был открыт Национальный Суперкомпьютерный Центр Барселоны, в котором находится MareNostrum — суперкомпьютер, обладавший на тот момент потенциалом в 42,35 Терафлопс. В ноябре 2006 года MareNostrum 2 удвоив число процессоров увеличил мощность до 94,21 Терафлопс. Последующие обновления, осуществлявшиеся в период с 2012 по 2013 год, довели производительность MareNostrum 3 до пиковых 1,1 Петафлопс с 48896 процессорами Intel Sandy Bridge в 3056 вычислительных узлах, в том числе 84 процессора Xeon Phi 5110P в 42 вычислительных узлах с 115 Тb оперативной памяти и GPFS-дисковой системой объемом в 2 петабайт. После последнего обновления в июле 2017 года самый мощный вычислительный центр Испании с пиковой производительностью в 13,7 Петафлопс занял 13-е место в мировом рейтинге суперкомпьютеров TOP500.

Функционально MareNostrum 4 разделен на две части. Блок общего назначения на 48 стоек включает 3456 вычислительных узлов, оснащенных процессорами Intel Xeon с 165888 ядрами и оперативной памятью в 390 Tb. MareNostrum 4 способен выполнять 11000 триллионов операций в секунду, что в десять раз больше, чем MareNostrum 3. Несмотря на это, потребление энергии возросло всего на 30% и сейчас составляет 1,3 МВт в год. Второй компонент MareNostrum 4 образован тремя технологически различными кластерами, которые можно добавлять или изменять в процессе создания. Первый Кластер содержит процессоры IBM Power9 и графические процессоры NVIDIA Tesla, имеющие те же компоненты, что и суперкомпьютеры Summit и Sierra. Второй Кластер сформирован из процессоров Intel Knights Hill (KNH), аналогичных тем, что стоят в суперкомпьютерах Theta и Aurora. Третий Кластер образован 64-битными процессорами ARM v8.

Но самое интересное, что MareNostrum расположен внутри церкви XIX века Torre Girona. Органично вписанный в строгий романский интерьер церкви, MareNostrum 4, в запуске которого непосредственное участие принимала компания Lenovo, используется для построения атмосферных и климатических моделей, в биомеханике, геофизике, социологии, различных исследованиях, материаловедении, для решения инженерных и других задач, использующих аналитику Big Data.

Экологичный data-центр Green Mountain в Норвегии

Несколько лет назад руководство норвежской компании Green Mountain, которая занимается предоставлением площадей в своих центрах обработки данных под размещение клиентского серверного оборудования, решило обыграть тему экологической привлекательности, которой операторы data-центров и корпоративные клиенты стали уделять повышенное внимание. Инженеры компании построили самый экологически чистый data-центр вблизи местности Ставангер в провинции Ругаланн в Норвегии. Они нацелились на оптимизацию системы охлаждения, на долю которой приходится основная часть потребляемой объектом электроэнергии. Инженеры использовали для этой цели воду из расположенного рядом фьорда, среднегодовая температура которой в среднем составляет 80С. Этот метод охлаждения вычислительных мощностей позволил Green Mountain добиться высокого коэффициента Power Usage Effectiveness (PUE) «мирового класса», а также уменьшить эксплуатационные издержки на 30% по сравнению со среднеуровневыми data-центрами. Чтобы обеспечить стабильность работы вычислительных мощностей и минимизировать риски простоя системы, владельцы data-центра наладили снабжение электроэнергией от трех независимых экологически чистых гидроэлектростанций. При этом энергетические компании, которые обслуживают объект, предлагают стабильную ценовую политику и возможность заключить контракт на поставки электроэнергии на срок до 10 лет. Кроме того, data-центр Green Mountain имеет нулевой углеродный след, в результате чего в атмосферу не попадает углекислый газ.

Data-центр разместился в пещерах, которые в недалеком прошлом служили складами боеприпасов НАТО. Оборудование клиентов размещается в подземных машинных залах, одна часть которых создавалась в традиционном стиле, тогда как при оборудовании второй части использовались контейнерные решения. Общая площадь data-центра составляет 22000 м2.

Data-центры Facebook и Google

У каждой из этих компаний несколько data-центров, но мы расскажем, пожалуй, о самых интересных. Открытый в 2013 году, data-центр в шведском городе Лулео, является первым центром обработки данных Facebook, находящимся за пределами США. Здание площадью в 30000 м2 расположено за полярным кругом, где морозный скандинавский воздух способствует естественному охлаждению серверов, максимально экономя потребление электроэнергии. Еще одним преимуществом локации, выбранной Facebook, являются возобновляемые источники энергии, а именно гидроэлектростанции, поскольку Лулео город-порт, раскинувшийся на фьорде Ботничевского залива. Размер дата-центра равняется площади 7,5 футбольных полей, а помещение настолько велико, что сотрудники передвигаются внутри него на скутерах. В центре трудятся 150 специалистов, в то время как на поддержку работы 25000 серверов Facebook требуется всего один человек.

Грандиозный data-центр Google расположен на берегу балтийского моря в городе Хамина в Финляндии. Его серверы находятся в бывших зданиях бумажной фабрики Suma Mill. Google потратил свыше 350 млн. долларов на приобретение и реконструкцию этих внушительных зданий, что является рекордной суммой для объектов подобного рода. Для охлаждения Google используют ледяные воды Финского залива, а электроэнергией data-центр питается от 24 турбинной гидроэлектростанции.

Сокровищница данных в Gak

Главный web-портал Южной Кореи Naver хранит свои файлы в data-центре Gak у подножия горы Губонг в Чунчхоне в провинции Канвон. Название Gak возникло как аналогия с Kyujanggak (королевская библиотека династии Чосон XVIII века), где хранились священные буддийские писания на деревянных блоках. В проекте нашлось применение и элементам традиционного дизайна, и современным экологическим технологиям, таким как повторное использование и рециркуляция дождевой воды. Стоимость строительства этого data-центра оценивается в 420 млн. долларов.

Пирамида Switch в… США

Невозможно не узнать оригинальный внешний вид центров обработки данных компании Switch с их запатентованными системами питания и охлаждения. Здание Switch Pyramid рядом с Гранд-Рапидс в штате Мичиган (США) представляет собой семиэтажную конструкцию из стали и стекла. 2 нижних этажа отведены под data-центр, а общая занимаемая площадь кампуса составляет 21000 м2. Data- центр построен по стандарту Tier IV Gold от Uptime Institute и работает полностью на возобновляемых источниках энергии. Построение 7-этажной пирамиды обошлось предыдущему владельцу в 111 млн. долларов в 1989 году. Одними из уникальных особенностей Switch Pyramid являются фасад из стекла и гранита, два подземных промышленных этажа, а также единственный в мире сферический маятник, который постоянно качается в атриуме data-центра между точками восхода и захода Солнца.

Следует отметить, что это далеко не все интересные проекты в сфере строительства data-центров. Data-центры располагаются на кораблях, как, например центр обработки данных компании IDS в США. В целях эксперимента и поиска бюджетных вариантов использования серверов data-центры размещались почти даже в обычных палатках. В экстремальных условиях уже долгое время функционируют data-центры на полярных станциях, в угольных шахтах и в известняковых пещерах. Главное, чтобы данные были защищены, а благодаря невысоким расходам самих data-центра, их услуги оставались доступными широкому кругу клиентов.