В 1950 году американские математики Меррил Флад и Мелвин Дрешер, работавшие на исследовательскую корпорацию RAND, предложили базовую модель «дилеммы заключенного» (Prisoner’s dilemma), которая с тех пор стала очень популярна среди математиков, философов и психологов.

В сущности, «дилемма заключенного» представляет собой проблему выбора оптимального решения в условиях, когда результат зависит от взаимосвязанных решений различных агентов. Но опустим заумные слова и заглянем в суть дилеммы — то есть в то, как она звучит:

Два заключенных обвиняются в совместном преступлении, которое карается десятью годами лишения свободы. Однако, если один из них признается в содеянном и свалит инициативу преступления на другого, то ему «скостят» срок заключения до трех лет, а другой получит сполна (10 лет). Если в преступлении сознаются оба, то им дадут по пять лет. Возможно, что оба заключенных будут отрицать свою причастность к преступлению, и тогда их отпустят на свободу за недоказанностью вины. Однако, для этого им нужно сговориться. Но заключенные содержатся в разных камерах и не могут согласовать свое поведение на допросе. Какое решение примет каждый из них?

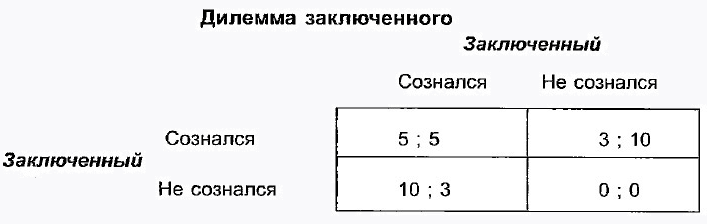

Схематически дилемму можно изобразить следующим образом:

Конечно же, каждый хочет, чтобы его отпустили на свободу, но для этого оба заключенных не должны сознаться. В то же время, несознавшийся рискует остаться в тюрьме на десять лет, если его напарник таки даст показания. Признаться или не признаться — вот в чем вопрос! Тут-то и начинается, как говорят в быту, «чистая психология».

По мнению математиков, поскольку в условиях некооперативного поведения человек стремится выбрать наименее рискованный для себя вариант, рациональным в данном случае будет предположение о худшем (подельник сознается). При такой стратегии оба преступника сознаются и получат по пять лет.

Но как в такой либо в похожей ситуации повел бы себя искусственный интеллект? Чтобы узнать это (и заодно изучить способность алгоритмов к социализации), ребята из DeepMind, подразделения Google, занимающегося разработками в области искусственного интеллекта, решили «стравить» друг с другом два ИИ-агента.

Для этого исследователи создали две примитивные видеоигры, в которых участники набирают наибольшее количество очков, если ведут себя эгоистично, однако если все участники будут преследовать исключительно свои интересы, то оба получат минимальное количество очков.

В первой игре под названием Gathering ИИ-агентам, представляющим красный и синий квадраты, дали задание собрать как можно больше «яблок» (желтые квадраты). Также игрокам разрешили по собственному усмотрению использовать лазер, чтобы временно обездвиживать противника.

В другой игре, Wolfpack, два ИИ преследуют «жертву» на территории с большим количеством препятствий. Очки получают все «охотники», которые на момент захвата находились рядом с «добычей», а не только тот, кто ее поймает. При этом игрокам, если они хотят скооперироваться, необходимо научиться обходить препятствия (серые квадраты) таким образом, чтобы не блокировать проход партнеру.

Исследование DeepMind показало, что искусственный интеллект адаптирует свое поведение к ситуации. Например, в Gathering ИИ-агенты поначалу вели себя достаточно мирно, не торопясь собирая яблоки, но чем меньше фруктов оставалось на поле, тем агрессивнее они становились и чаще хотели выбить друг друга из игры. При этом, чем алгоритм был мощнее, тем чаще он использовал «оружие» вне зависимости от количества доступных яблок. Таким образом, более развитый ИИ предпочитал быть агрессивным во всех ситуациях.

А вот во второй игре, где, в отличие от первой, важным фактором победы была кооперация, а не конкуренция, ситуация оказалась противоположной. Здесь ИИ-агенты показали большую тягу к взаимодействию, так как это было отчетливо выгодно им обоим.

О чем говорят полученные результаты?

Неожиданную на первый взгляд агрессивность сильных алгоритмов в Gathering ученые объяснили, как ни странно, доступной вычислительной мощью, а не скрытой тягой продвинутого ИИ к убийству себе подобных. Чем мощнее система, тем больше заданий она выполняет. В данном случае использование лазера для выведения из строя противников — это просто дополнительная задача.

В Wolfpack, напротив, кооперация дает преимущество, поэтому ИИ — как мощный, так и более слабый — вели себя достаточно миролюбиво.

Отдельно исследователи DeepMind подчеркивают, что не стоит очеловечивать искусственный интеллект и считать, что он будет преследовать свою выгоду, не останавливаясь ни перед чем, включая убийство. Алгоритмы следуют строгим правилам и в соответствии с ними меняют свое поведение. Другими словами, речь не идет о том, что в Gathering мощный алгоритм пришел к какому-то выводу, который бы выходил за рамки условий эксперимента.

Напоследок отметим, что поведение алгоритмов при решении социальных дилемм уже давно интересует DeepMind. Таким образом в Google хотят найти ответ на вопрос, в каких ситуациях ИИ готов конфликтовать с «сородичами». Это крайне важно знать, если в будущем искусственный интеллект действительно возьмет на себя решение задач в реальном мире. Например, ученых интересует, как разрешится ситуация, если один ИИ-агент управляет дорожным движением по всему городу, а другой — стремится сократить выбросы углекислого газа.

«Такие исследования позволяют нам лучше понимать и контролировать сложные системы с несколькими ИИ-участниками, к примеру, экономику, дорожное движение и экологию на планете», — отметили в конце руководители эксперимента.